기후위기로 인한 영향력이 전 세계적으로 확대되고 있는 가운데 각 국가들은 온실가스 저감을 위한 다양한 방안을 마련하고 있다. 이러한 온실가스 저감 분위기가 고조됨에 따라 미래산업의 기반시설로 인정받고 있는 데이터센터(DC: DataCenter) 역시 막대한 전력사용량을 줄일 수 있는 대책마련을 고심 중이다.

유럽 주요국가들을 필두로 데이터센터에 대한 전력수요관리와 환경제재가 강화되고 있으며 글로벌 데이터센터 기업들은 지속가능한 운영을 위한 쿨링솔루션 개선에 적극적이다. 특히 IT장비 자체를 냉매에 넣어 냉각하는 액침냉각(Immersion cooling) 도입이 적극적으로 검토되고 있다.이와 관련해 한국설비기술협회(회장 김철영) 데이터센터기술위원회(위원장 연창근)는 11월1일 The RAUM 컨벤션에서 ‘데이터센터 신 냉각기술’을 주제로 세미나를 개최해 초고밀도 컴퓨팅시스템을 냉각할 수 있는 액침냉각 기술에 대한 정보교류의 장을 열었다.

이번 기획기사에서는 데이터센터 액침냉각 기술동향 및 해외사례를 살펴본다.

DC 전력량 해소 ‘시급’

4차 산업혁명이 우리 사회 깊숙이 뿌리내리고 있는 가운데 모든 산업에서는 데이터를 기반으로 한 디지털전환이 가속화되고 있다. 또한 코로나19 팬데믹으로 인해 비대면산업의 발전은 매 순간 생산되는 데이터량을 비약적으로 증가시켰다.

세계 최대의 컴퓨터 제조기업이자 IT솔루션을 제공하고 있는 IBM에 따르면 오늘날 하루에 생산되고 있는 데이터량은 약 25억GB(기가바이트)에 달하며 Seagate는 전 세계 데이터양은 2025년까지 연간 175ZB로 증가할 것이라고 전망했다.

생산된 막대한 데이터가 저장되는 곳은 데이터센터다. 앞으로 더욱 고도화될 디지털사회가 유지될 수 있는 기반시설로 데이터센터가 지목되는 이유다.또한 데이터센터는 많은 전력량을 사용하고 있으며 서버의 고집적·고밀도화로 인해 전력사용량은 더욱 늘어날 전망이다.한전에 따르면 국내 상업용 데이터센터는 2022년 6월 기준 146개소가 운영되고 있으며 1,742MW를 사용하고 있다. 2029년까지 전기사용예정통지를 신청한 수요는 466개소, 3만2,263MW로 파악된다.

대형 데이터센터 1개소의 전력사용량은 중소도시 전체가 사용하는 양과 비슷하기 때문에 한국산업이 미래시장에서 경쟁력을 유지하고 지속적인 발전을 이루기 위해서는 데이터센터의 막대한 전력수급문제를 해결해야 한다.

효율적 냉각설계 ‘핵심’

데이터센터의 전력사용은 크게 데이터를 저장, 처리하는 서버와 이러한 서버를 유지시키기 위한 공조 및 인프라 등으로 나뉜다. 데이터센터 본연의 역할을 수행하는 IT서버는 줄일 수 있는 대상이 아니기 때문에 데이터센터 에너지절감은 서버 외 부분 중 가장 큰 전력사용량 비중을 차지하고 있는 공조설비를 얼마나 효율적으로 구성하느냐에 달려있다. 이를 수치화한 것이 PUE(Power Usage Effectiveness: 전력효율지수)로 데이터센터의 총 전력량을 IT장비 전력량으로 나눈 값이며 1에 가까울수록 전력효율이 좋은 데이터센터로 평가받는다.

글로벌 데이터센터의 평균 PUE는 지속적으로 향상되고 있지만 2021년 약 1.6 수준으로 조사되고 있다.

조진균 한밭대 교수는 “2014년 이후 PUE는 크게 향상되지 못했는데 PUE 1.6 이상 데이터센터가 5kW 이하의 비적 저밀도 랙-서버가 지배하기 때문”이라며 “평균 IT전력밀도가 높을수록 데이터센터가 보다 에너지효율적으로 설계될 수 있는 가능성이 높다”고 말했다.

글로벌 데이터센터 운영기업은 PUE를 낮추기 위한 다양한 시도를 하고 있으며 아주 추운 지역에서 외기냉기를 도입하거나 바닷속에 데이터센터를 구축하는 등의 노력을 하고 있다.

국내 데이터센터의 평균 PUE는 1.8x로 조사되고 있어 갈수록 늘어나고 있는 전력사용량을 줄이기 위해서는 데이터센터 공조효율화가 절실한 실정이다.

밀도 따라 냉각방식 변화

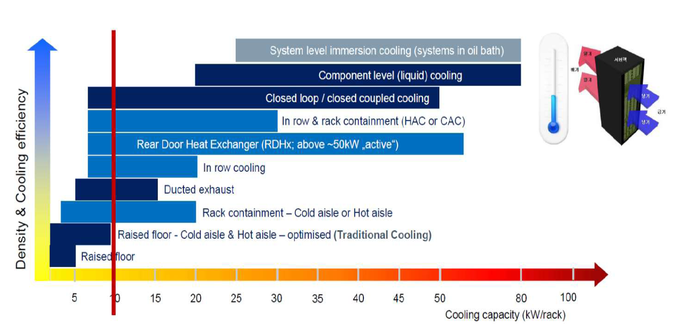

데이터센터의 냉각방식은 IT서버의 발열, 즉 랙의 전력밀도에 따라 진화해왔다. 5kW 미만 저밀도에서는 공간단위 냉각방식(Room-based cooling)을 사용했으며 6~17kW에서는 열기반 냉각방식(Row-based cooling)을 적용할 수 있다. 11kW 이상 고밀도에서는 랙기반 냉각방식(Rack-based cooling)이 서버에서 나오는 열부하를 효과적으로 제거할 수 있다.

공간단위 냉각방식은 공조공기를 공급하는 CRAC 유니트와 IT장비의 거리가 최대 15m 이상으로 이동경로가 길기 때문에 열량이 손실되고 실내공기가 혼합돼 온도가 상승하는 비효율성이 증가한다. 이러한 단점을 보완하기 위해 차가운 공기와 뜨거운 공기가 일방통행으로 다닐 수 있도록 열복도/냉복도(Hot aisle/Cold aisle)를 설계해야 한다.

열기반 냉각방식은 8~15kW 전력밀도에 적합하며 랙 사이 냉각할 수 있는 In Row Type 쿨러를 설치한다. 최고 30kW까지 처리가 가능하며 기류흐름이 2~3m로 짧고 효율성이 좋다. Row마다 안정성 확보를 위해 예비를 설치해야 하며 수배관이 설치돼있어 누수위험에 대비할 수 있는 시스템을 같이 구축해야 한다.

랙기반 냉각방식은 15kW 이상 전력밀도에서 반드시 고려돼야 한다. 랙 뒷면에 Passive Rear Door(W/Cooling Coil)를 설치해 서버를 냉각하는 방법이다. 최고 50kW까지 처리가 가능하며 Rear Door Fan 고장 시 팬이 담당하고 있던 부하처리에 불리할 수 있어 고장 시 Rack Down이 발생할 수 있다. In Row타입과 동일하게 누수위험성이 있다.

D2C(Direct to Chip) Cooling 방식은 서버 내 발열이 많이 발생되는 CPU, RAM, VGA에 냉수가 직접 공급될 수 있도록 수냉 블록을 설치하고 발열을 직접 제거함에 따라 최고 50kW까지 처리가 가능하다.

고밀도·고집적화 가속

데이터센터에서 사용되는 IT서버 기술이 발전함에 따라 서버의 고밀도·고집적화가 가속화되고 있다. DATA CENTER Frontire의 ‘2020년 데이터센터 현황보고서’에 따르면 데이터센터의 평균 랙밀도는 2018년 7.2kW에서 2019년 7.3kW, 2020년 8.2kW로 증가하며 상승폭은 매년 크게 증가할 전망이다.

CPU TDP(열설계전력) 트렌드는 2009년 W5590(4C/8T) 130MW에서 2019년 XEON PLATINUM 9282(56C/112T)의 400W로 늘었으며 GPU TDP는 2009년 Tesla C1060 188W에서 2019년 HGX3의 400W로 증가했다. 최근 엔비디아의 지포스 4090의 전력량은 450W로 출시됐다. 이처럼 기본적인 칩셋의 전력량은 상승폭을 그리고 있음에 따라 데이터센터 공조설계도 더욱 고밀도·고집적화돼야 할 것으로 보인다.

액침냉각 단점 보완 진화

아직 국내에서는 생소하지만 AI, 가상화폐 채굴 등을 목적으로 하는 해외 데이터센터에서는 초고밀도 전력부하를 해결하기 위해 액침냉각방식을 도입하고 있다.

액침냉각은 서버를 전기가 통하지 않는 액체에 담그는 방식으로 50kW 초고밀도 부하에 대응할 수 있다. 100% liquid 냉각방식으로 고밀도서버를 냉각시키기 위해 가장 적은 에너지를 사용한다.

액침냉각은 서버 전체를 열전달속도가 높고 열저항이 낮은 유체에 침지한다. 변압기에 들어간 절연유와 같이 비전도성 액체로 별도의 Heat Rejection System(C/T, Dry Cooler 등)을 통해 서버를 냉각, 온도가 상승된 액체의 열을 제거하기 때문에 압축기, 팬 등 소요동력이 큰 장비가 필요없다. 열의 전달매체인 물은 공기와 비교해 비열 및 밀도가 커 열용량이 높다. 냉각시스템 관리가 매우 효율적이며 안정적이라는 장점이 있다.

이러한 방식으로 냉각되는 IT하드웨어에는 별도의 팬이 필요하지 않으며 열교환기를 채택해 데워진 냉각수를 효율적으로 순환, 열교환한다.

액침냉각 방식도 탱크 내 IT하드웨어를 직접 담궈 냉각하는 방식이 현재 사용되고 있지만 장비의 유지보수에 어러움이 발생하고 비전도성 용액을 탱크에 충진하기 때문에 장비의 중량 및 용액의 과다사용에 따른 문제점이 발생한다.

이러한 단점을 해소하기 위한 방편으로 정밀 침수 냉각방식(캐비넷형)으로 진화하고 있다. PUE는 동일하며 용액 사용량은 탱크사용 시보다 1/10 이하로 줄일 수 있다. 액침냉각을 사용하기 위해서는 서버제조기업에서 가능한 부품을 제공해야 하지만 일반서버에 비해 부족한 상황이다.

또한 초기 투자비를 많이 들여 빠른 발열제거가 가능한 시스템을 구축해도 기술발전속도가 빨라 예상보다 오랜기간 사용이 불가능한 문제도 있다. 침수냉각에 따라 장비수명이 늘어나도 현재 하드웨어 발전속도가 너무 빨라 금방 구형이돼 가상화폐나 AI 연산속도 측면에서 불리해진다.

산업용 열전달 냉각체는 탄화수소화합물(Hydrocarbon)과 불소화합물(Fluorochemical)로 나뉜다. 탄화수소화합물은 오일이 포함되는 일반적인 냉각체로 경제적이지만 가연성이 있다. 불소화합물은 안정적이고 불활성물질이지만 탄소수소화합물보다 높은 단가가 단점이다.

액침냉각은 두 가지 방식으로 사용되고 있다.

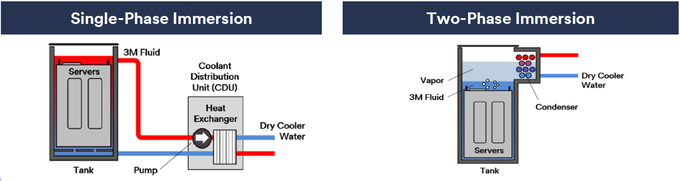

1-Phase Immersion Cooling System은 유전체 용액을 서버에 순환시켜 냉각하는 방식이다. 서버 내 냉각은 대류 열전달방식이며 탱크 내부의 순환이 원활해야 하기 때문에 유로가 중요한 요소다. CDU가 부가적으로 필요하며 CDU 1대당 다수의 랙 연결이 가능하다. 액체를 담궈둔 서버와 CDU가 분리돼있어 기본적으로 펌프동력이 필요하다. CDU의 주요부품을 탱크에 내장하는 방법, 펌프의 순환없이 열순환에 의해 냉각하는 패시브형식의 제품도 존재한다.

2-Phase Immersion Cooling System은 유전체 용액이 서버열에 의해 기회되고 기화된 용액은 상부 열교환기에서 응축시켜 액화 후 순환, 냉각하는 방식이다. IT장비에서의 냉각메커니즘은 boiling이며 기화된 용액을 응축시키는 메커니즘은 condensation이다. 탱크 내부에 설치된 응축부에 냉수를 공급하는 방식으로 기체상태의 냉매가 순환하기 때문에 부가시설이 필요치 않지만 기밀관리가 필요하다. 탱크 내부에 냉매 외 공기가 유입될 시 냉각성능이 감소할 수 있어 벨로우즈 설계에 유의해야 한다.